Meta 稍早宣布推出可識別超過4000種口語表達語言的大型多語言模型 (Massively Multilingual Speech AI ),並且對外開源提供使用,讓語言研究社群能藉此資源繼續推動保存更多既存語言工作。

相比去年提出全球首款以語音對語音翻譯,讓閩南語能直接翻譯成英語的技術,Meta此次提出大型多語言模型可對應超過4000種口語表達語言,識別數量是現有技術的40倍,並且能藉此用在擴增實境、虛擬實境等應用,讓所有人能以各自習慣語言進行溝通。

而提出此模型,Meta更表示能以此技術保留多數口傳語言,進而保留更多文化資產。

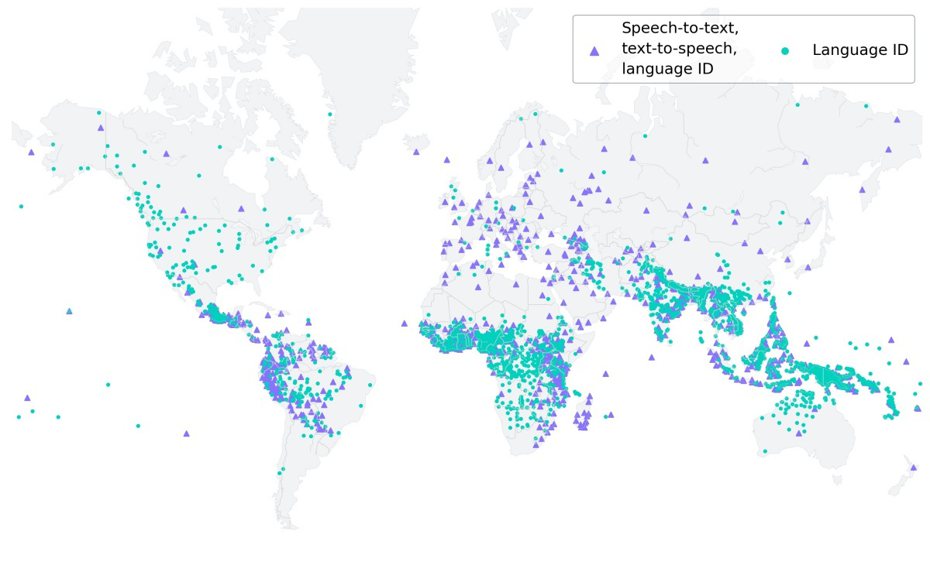

此項技術源自既有文字轉語音,以及語音轉文字技術應用範圍,從最初僅對應100種語言,目前已經能轉換超過1100種語言,甚至能識別超過4000種口語語言,藉此讓不同語言使用者能順利溝通。

在此技術背後,則是使用被翻譯成多種語言,並且被廣閱讀、研究的宗教經典,例如在全球有許多人閱讀、翻譯的聖經,便是此技術其中一個被用於訓練的文字資料。

Meta透過被翻譯成1100種語言的新約聖經有聲讀物資料,平均每種語言的語音資料長度達32小時,後續再加上未經標註的基督教有聲讀物,使得訓練資料對應超過4000種語言。

雖然蒐集資料是以男性聲音呈現居多,但訓練之後的模型依然能準確識別男、女聲所表達內容。而即便訓練使用資料多半為宗教相關內容,但訓練結果並不會因此自動產生更多宗教相關內容。

Meta表示,接下來將持續擴大型多語言模型對應語言,並且支援更多語言之間識別及轉換,藉此克服更多以現有技術難以處理的方言內容。

《原文刊登於合作媒體mashdigi,聯合新聞網獲授權轉載。》

討論區