在生成不準確的歷史圖片後,Google 暫停了Gemini 生成人物圖片的功能,並表示很快就會發布改進的版本。

所謂不準確的歷史圖片,指的是一些Gemini使用者在請該AI模型描繪歷史群體或人物(如開國元勳)的圖片時,發現Gemini似乎有意識地避開生成白人的圖片,包括如果要求Gemini生成「1800年代美國參議員」,得到的結果會包括黑人和美國原住民女性,不過歷史上第一位女性美國參議員卻是在1922年才有,且還是白人。此外,在生成「二戰德軍」的圖片時,居然出現了由黑人、亞裔女性穿著德軍軍裝的照片 ,與歷史嚴重不符,Gemini更被認為是「在消除種族與性別歧視的歷史」。

AI新創公司Hugging Face首席道德科學家Margaret Mitchell表示,Gemini之所以產生不符歷史事實的例子,可能是由以下幾種類型干預造成的。她表示,Google可能「在幕後」為使用者的prompt添加了種族多樣性的術語。在這種情況下,像「廚師的肖像」的prompt,就可能會變成「原住民廚師的肖像」。在這種情況下,Google可能隨機選擇附加的術語,並且也可能添加多個多樣性術語。

Mitchell說,Google也可能更優先顯示深色膚色生成的圖片。例如,如果Gemini為每個prompt產生10張圖片,Google會讓系統分析圖片中描繪的人物的膚色,並將膚色較深的人的圖片推到隊列中的優先位置。因此,如果Gemini只顯示前4張圖片,那麼最有可能看到膚色較深的圖片。

這則新聞已經在美國社群媒體上引起熱烈討論,尤其是右翼人士對此猛烈批評,過去他們經常批評如今的社群媒體環境以及 AI 工具都太偏向自由主義,不過 Google 以及其他科技公司卻對於AI可能加深種族偏見感到擔憂,因此相當強調少數族裔以及有色人種的代表性,但如今卻出現了過度糾正的問題。

現在生成人物圖片的能力已經被 Google 暫時撤下,若使用者要求,會看到Gemini回應:「我們正在提升Gemini生成人物影像的能力,預計此功能很快就會回歸,並會在發布更新時通知您。」

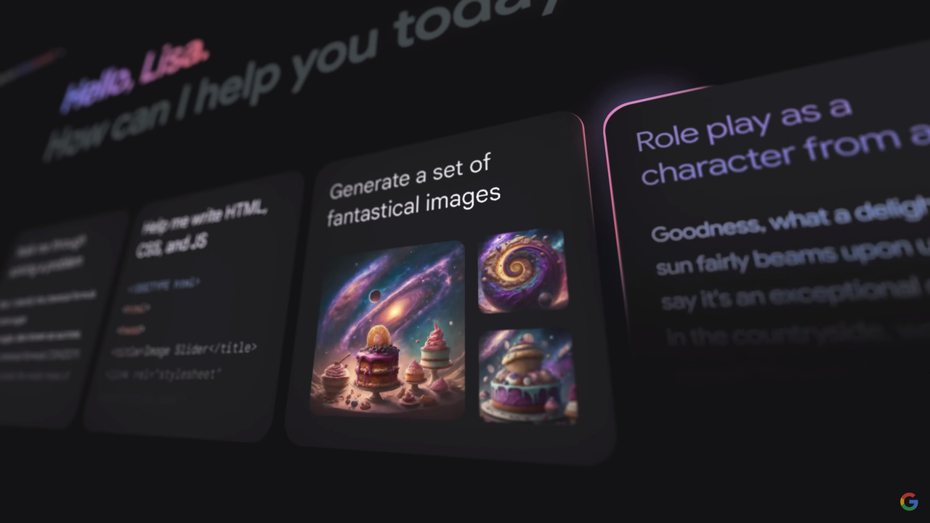

Gemini生成圖片的能力是Google在本月稍早時開放的,以和OpenAI 以及微軟 Copilot 等對手競爭。

《本文作者Sisley,原文刊登於合作媒體INSIDE,聯合新聞網獲授權轉載。》

訂閱《科技玩家》YouTube頻道!

💡 追新聞》》在Google News按下追蹤,科技玩家好文不漏接!

📢 便宜資費懶人包/5G 399元搶市!不限速吃到飽方案比4G划算

📢 CMF Headphone Pro耳罩式耳機開箱!實測動感滑桿聽見動ㄘ動、驚豔降噪高CP

📢 坐飛機遇行充自燃怎麼辦?專家曝溫度控制就用它:亂用1物會更慘

📢 iPhone鬧鐘「沒響」錯過航班!網紅抱怨引出一票苦主 2招避免中招

📢 HTC VIVE Eagle智慧眼鏡開箱!日本實測AI翻譯菜單 聽音樂驚豔、拍出日系照片

📢 懶人包/台灣吉伊卡哇常設店12月27日開幕!13樣新品、贈品、地點一次看